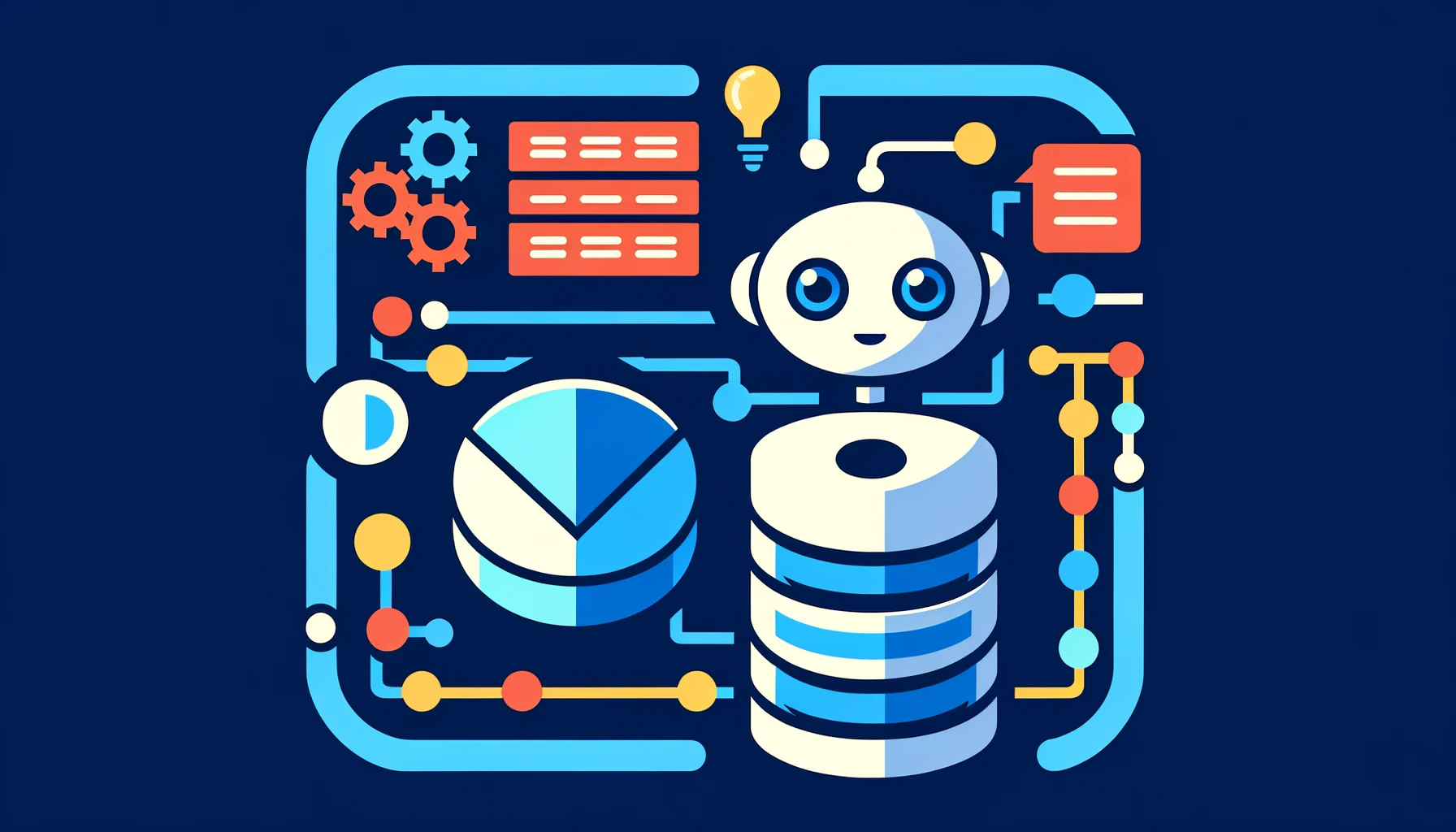

La génération augmentée de récupération (RAG, retrieval-augmented generation) est une approche architecturale améliorant l'efficacité des applications de modèles de langage volumineux (LLM) en exploitant des données personnalisées. Cette technique consiste à récupérer des données/documents pertinents pour une question ou une tâche et à les fournir comme contexte au LLM, se révélant particulièrement efficace dans les chatbots de support et les systèmes de questions-réponses nécessitant des informations à jour ou un accès à des connaissances spécifiques à un domaine.

Les Limitations des Modèles de Langage Volumineux (LLM)

Les LLMs utilisent des modèles d'apprentissage profond et sont entraînés sur d'énormes ensembles de données pour comprendre, résumer et générer du contenu inédit. Cependant, une fois formés, de nombreux LLMs ne peuvent pas accéder à des données au-delà de leur point de coupure de données d'entraînement, les rendant statiques et susceptibles de répondre incorrectement, de fournir des réponses obsolètes ou de "halluciner" lorsqu'on leur pose des questions sur des données non incluses dans leur formation.

Fonctionnement

La RAG, en tant que norme de l'industrie, permet d'utiliser ses propres données en les fournissant dans le cadre de la requête adressée au modèle LLM. Au lieu de se fier uniquement aux connaissances dérivées des données d'entraînement, un flux de travail RAG extrait des informations pertinentes et connecte des LLMs statiques avec une récupération de données en temps réel. Ainsi, les organisations peuvent déployer n'importe quel modèle LLM et l'augmenter pour renvoyer des résultats pertinents en lui donnant une petite quantité de leurs données sans les coûts et le temps nécessaires à un ajustement fin ou à un pré-entraînement du modèle.

Les avantages clés de la RAG comprennent la fourniture de réponses à jour et précises, la réduction des réponses inexactes ou des hallucinations, la fourniture de réponses pertinentes et spécifiques au domaine, et une efficacité et un rapport coût-efficacité supérieurs par rapport à d'autres approches de personnalisation des LLMs avec des données spécifiques au domaine.

Avantages de l'Implémentation du RAG dans les Entreprises

The memories and experiences gained from travel can last a lifetime, making it an investment in personal growth and happiness. Whether it's solo or with loved ones, traveling is a wonderful way to create meaningful experiences and make life-long memories.

1. Réponses Plus Précises et à Jour

La RAG permet aux systèmes d'IA de fournir des réponses non seulement précises mais également actualisées, en s'appuyant sur les dernières données disponibles. Cela est crucial pour les entreprises où les informations changent rapidement.

2. Personnalisation et Contextualisation

Avec la RAG, les entreprises peuvent personnaliser les réponses générées par l'IA en fonction de leurs propres bases de données et connaissances spécifiques au secteur, offrant ainsi des réponses plus pertinentes et contextuelles.

3. Efficacité Opérationnelle

En réduisant le besoin de mises à jour et d'entraînement fréquents des modèles d'IA, la RAG peut diminuer les coûts opérationnels et le temps nécessaire pour maintenir les systèmes d'IA.

4. Sécurité et Conformité

La RAG aide à minimiser les risques de fuites de données sensibles et assure que les réponses générées sont conformes aux réglementations et politiques internes de l'entreprise.

5. Scalabilité et Adaptabilité

La RAG permet aux entreprises de facilement adapter et étendre leurs systèmes d'IA pour répondre à des besoins changeants, sans nécessiter de restructuration majeure ou de réentraînement coûteux.

En résumé, la RAG représente une avancée significative dans le domaine de l'IA, permettant une utilisation plus efficace et contextuelle des modèles de langage dans diverses applications, notamment les chatbots et les systèmes de questions-réponses.